Table des matières

Traitement

Le débat sur les dangers de l'Open Data

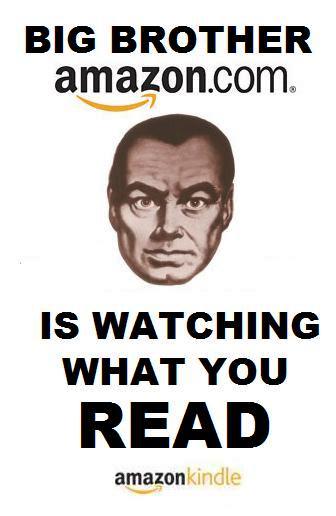

L’Open data est dangereux selon Gaetan Gorce (député PS, rapport Sénat avril 2014). On croit aller dans le sens des libertés publiques, mais il y a des risque très importants sur la vie privée.

Il suffit en effet, aux entreprises privées de recouper et de croiser les données publiques et privées pour profiler tout le monde. La perspective d'un cauchemar totalitaire se précise alors : les données carroyées de l’Insee sur les revenus -carré de 200m sur 200m- ont dû ainsi, être retirées en catastrophe, car utilisées pour identification, sur de nombreux sites web.

Les partisans de l’Open Data, récusent tout risque car il y aurait un cadre juridique efficace, avec la loi CADA de 1978 installant un droit de réutilisation des infos publiques, sauf « si vie privée-secret médical –secret commercial et industriel, secret statistique ». Voir les articles nombreux de Sabine Blanc de la Gazette des communes, qui fait des points juridiques réguliers.

Le problème, cependant, n’est pas l’Open data en lui-même (avec des données anonymes) mais l’usage qui en est fait ensuite avec croisement des données personnelles. Selon l’association Regards Citoyens et le rapport Bouchoux du Sénat (juin 2014), la loi CADA protège suffisamment, notamment, car les données Open Data sont en licence réutilisables.

Cependant, la CNIL en France, et le Préposé à la protection des données en Suisse, sont sur une position très méfiante, envers le Big Data, et par extension l'Open Data : “La difficulté que présentent les données « factuelles » ou « anonymisées » dans le cadre des données massives est qu'on ne peut pas exclure que le rapprochement de plusieurs collections de données n'entraîne une désanonymisation”. De nombreuses interrogations apparaissent donc sur la qualité actuelle de la protection de la vie privée.

Les risques du profilage

Un service plus efficace ?

L’approche BIG DATA permet de profiler la population pour lui rendre un service théoriquement plus efficace (et donc plus profitable). C’est évidemment sur ce dernier point que se concentrent les entreprises.

La segmentation marketing est ainsi bouleversée par ces approches (qui aboutissent à une personnalisation extrême et automatisée des relations commerciales). A titre d’exemple (voir ici) on peut citer :

- Annonces display profilées en temps réels avec récupération de données privatives auprès de grands collecteurs de données (Les GAFA : Facebook, Amazon, Apple, Google…)

- La relance de la clientèle en temps réel lorsqu’il navigue sur un site (et menace de le quitter), et la personnalisation de l’information diffusée sur le site (avec constitution automatique de dossier de suivi avec relance personnalisée, marketing automation) Cela relève de l’analyse comportementale.

- L’analyse prédictive (on anticipe le comportement) à partir de l’information récoltée en interne sur des DMP (Data Management Platforms.

Cette dernière famille d’utilisation trouve des déclinaisons très nombreuses comme déjà vu plus haut : gestion des risques (par exemple, risques clients assurance), mesure des performances (exemple : notation des enseignants), optimisation des activités humaines (répartition des circuits de bus, logiciel des Pompiers de Paris), cartographies des marchés (services pour immobilier, tourisme etc.), mais aussi invention d’applications mobiles personnalisées et agrégeant des informations.

La question des finalités du profilage

Le problème est que ces nouveaux services, sont conçus, pensés, réalisés, dans une optique implicite d'amélioration de l'appariement offre/demande afin de générer de la valeur ajoutée et une rentabilité supplémentaire.

Or ces “objectifs marchands” entrent souvent en conflit, avec d'autres objectifs sociaux ou politiques.

Par exemple, faut il subordonner les libertés politiques à ces buts marchands ? Les techniques de profilage dérivées du Big Data font craindre le risque de passage à un néo-totalitarisme, du type « Bienvenue à Gattaca » (où l'on décrit un profilage génétique, en matière de santé, fondé sur des modèles probabilistes, qui peut par exemple entraîner des logiques de ségrégation). De nombreux articles et réflexions critiques remettent en cause les bienfaits supposés de l’analyse massive de données. Par exemple, en matière de santé ou encore en général.

La question des algorithmes et des systèmes experts

*Ouvrir la boite noire*

Les algorithmes suivent un modèle sous-jacent (paramètres, étapes de traitements, choix de décision) qu’il est nécessaire aujourd’hui d’interroger. En effet, les algorithmes prennent aujourd’hui, de plus en plus une place centrale sans que cela soit clairement perçu par les citoyens, usagers ou clients : ils sont invisibles.

Selon D. Cardon, la société de calcul qui s’annonce nécessite d’ouvrir la « boite noire » des algorithmes, qui constituent une manière de classer et de hiérarchiser l’information numérique : « La manière dont nous fabriquons les outils de calcul, dont ils produisent des significations, dont nous utilisons leurs résultats, trame les mondes sociaux dans lesquels nous sommes amenés à vivre, à penser, à juger » (Dominique Cardon, op.cit., p.14)

D. Cardon distingue 4 familles de calculs, structurant successivement et profondément, les comportements sociaux actuels :

- la mesure de la popularité (le nombre de clics, l’audience chiffrée à la manière du compteur de vues Youtube ou des meilleurs ventes Amazon, produisant un risque accru de conformisme),

- la mesure de l’autorité, du mérite, de l’expertise (par le nombre de liens croisés à la manière du PageRank de Google, produisant un risque accru de censure et de concentration de l’autorité),

- la fabrique de la réputation (le nombre de reprises sur les réseaux sociaux, à la manière des Likes de Facebook ou des re-tweets de Twitter, réseaux expressifs, exposants au risque de fraudes et au risque d’enfermement dans la bulle de ses préférences)

- et enfin la prédiction par les traces, au moyen invisible des algorithmes : avec un « futur de l’internaute prédit par le passé de ceux qui lui ressemblent » (D. Cardon, op.cit. p.34).

Cette révolution dans la manière de classer les informations numériques ouvre de nombreux risques (par exemple, la capture marchande des objectifs, ou encore la montée en puissance des logiques conservatrices) et tend à s’imposer (par exemple, Google abandonne peu à peu le PageRank, pour s’appuyer sur les choix passés des internautes qui sélectionnent un résultat dans une liste de résultat). Le dangers des algorithmes

Peut-on confier nos destins aux algorithmes, sans appréhension, quand on observe les difficultés actuelles en matière de Trading haute fréquence ? Le jugement dit objectif des algorithmes est-il plus souhaitable que le jugement subjectif des hommes, quand la conséquence d’une erreur d’algorithme impacte des millions de vies ?

Il y a par exemple des dérives en matière de lutte contre le terrorisme (par exemple, un pilote d’avion américain, ressort systématiquement comme suspect, 80 fois début 2015, en raison d'un profil repéré par les algorithmes de sécurité). Un article influent de Luke Dormehl (11/2014 Wired) recense de nombreux exemple d’erreurs de prévision de ce type “des faux positifs”, ce qui souligne à contrario l'efficacité du jugement de l'expert humain.

Plus généralement, connaît-on vraiment les nouvelles lois qui nous gouvernent de plus en plus, sous la forme des suggestions efficaces des algorithmes de recommandation ? De nombreux penseurs insistent sur la nécessité d'ouvrir les modèles qui nous gouvernent (Cf. Cathy O Neil ou Mike Lokides, cités par Hubert Guillaud), et sur la nécessité de mettre en place des régulations politiques, sociales, éthiques, donc juridiques (voir à ce propos l'ouvrage de Eric Sadin, “La vie algorithmique : critique de la raison numérique” (03/2015, Échappée Editions).